Highlight:

Prompt engineering merupakan keterampilan yang sangat penting dalam memaksimalkan pemanfaatan AI. Dengan memahami prinsip-prinsip dasar serta menerapkan strategi optimasi yang tepat, pengguna dapat meningkatkan kualitas dan relevansi output AI. Struktur LLM yang kompleks, seperti kombinasi Draft LLM, Critique LLM, dan Final LLM, memungkinkan AI menghasilkan jawaban yang lebih akurat.

Prompt engineering adalah teknik yang digunakan dalam berinteraksi dengan kecerdasan buatan atau artificial intelligence (AI), khususnya large language models (LLM), untuk memperoleh output yang akurat dan sesuai dengan kebutuhan pengguna. Di sini akan dijelaskan konsep dasar prompt engineering, strategi dalam mengoptimalkan hasil yang dihasilkan AI, serta tantangan dalam penerapannya. Dengan memahami teknik ini, pengguna dapat memanfaatkan AI secara efektif dalam banyak bidang, seperti analisis data, natural language processing (NLP), dan pengambilan keputusan berbasis AI.

Seiring dengan berkembangnya teknologi AI, terutama LLM seperti ChatGPT, peluang untuk meningkatkan produktivitas dan efisiensi menjadi semakin luas. Namun, kualitas output AI sangat bergantung pada cara prompt atau instruksi diberikan. Oleh karena itu, pemahaman mengenai prompt engineering menjadi sangat penting agar AI dapat memberikan respons yang optimal dan relevan. Tulisan ini akan membahas prinsip, teknik, serta tantangan yang muncul dalam menerapkan prompt engineering untuk meningkatkan interaksi dengan AI.

Struktur Large Language Models

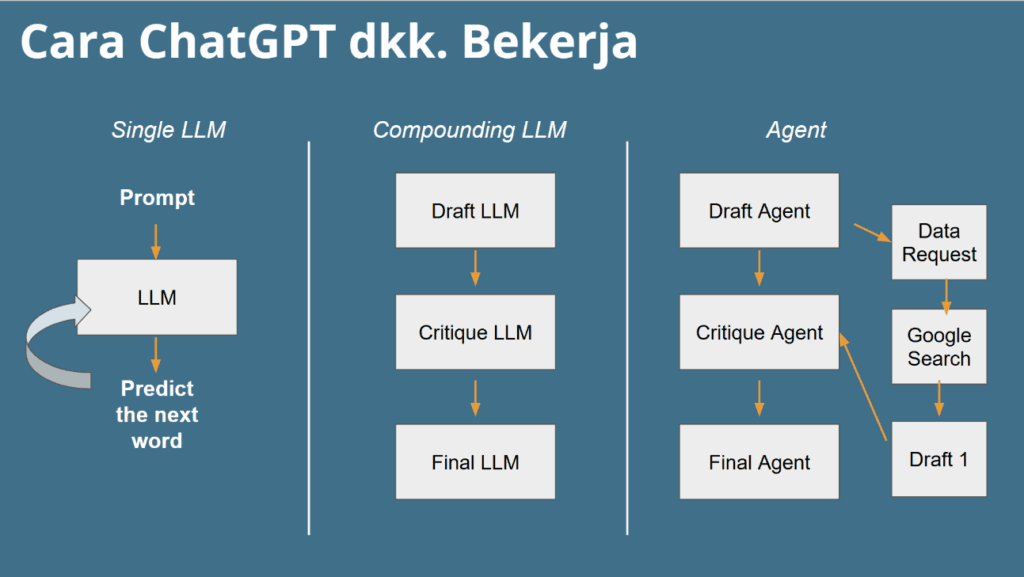

Large language models (LLM) adalah sistem AI yang dilatih menggunakan sejumlah besar data untuk memahami dan memprediksi kata atau kalimat dalam berbagai konteks. LLM beroperasi dengan cara memproses input (prompt) dan menghasilkan output berdasarkan probabilitas kata atau frasa yang paling mungkin sesuai dengan pola yang telah dipelajari selama pelatihan.

Pada praktiknya, terdapat beberapa pendekatan dalam struktur LLM yang bertujuan untuk meningkatkan akurasi serta kualitas respons yang dihasilkan. Salah satu pendekatan tersebut adalah sistem berlapis yang terdiri dari Draft LLM, Critique LLM, dan Final LLM. Draft LLM berfungsi sebagai generator awal yang menyusun respons pertama berdasarkan prompt pengguna. Selanjutnya, Critique LLM bertugas mengevaluasi jawaban awal, mengidentifikasi kesalahan, serta memberikan saran perbaikan. Terakhir, Final LLM menyempurnakan respons berdasarkan masukan dari Critique LLM sehingga jawaban yang dihasilkan menjadi lebih akurat, terstruktur, dan relevan. Pendekatan ini memastikan bahwa output AI tidak hanya dihasilkan melalui satu tahap pemrosesan, tetapi melalui beberapa lapisan evaluasi untuk mencapai kualitas yang lebih tinggi.

Prinsip Dasar Prompt Engineering

Pada penerapan prompt engineering, terdapat beberapa prinsip dasar yang perlu diperhatikan agar instruksi yang diberikan kepada AI dapat dipahami dan diproses dengan baik. Prinsip pertama adalah kejelasan dan spesifik, di mana prompt yang jelas dan tidak ambigu akan membantu AI menghasilkan jawaban yang lebih tepat. Kedua, penyediaan konteks sangat penting karena informasi tambahan, seperti peran yang harus dimainkan oleh AI, akan membantu meningkatkan relevansi respons.

Prinsip ketiga adalah penentuan format jawaban, yang memungkinkan pengguna mendapatkan hasil dalam bentuk yang lebih sistematis, seperti tabel, daftar, atau paragraf. Prinsip keempat, penggunaan contoh akan dapat membantu AI memahami ekspektasi pengguna dengan lebih baik. Prinsip kelima, pengaturan gaya bahasa, baik formal, santai, maupun teknis, akan memastikan bahwa jawaban yang diberikan sesuai dengan kebutuhan dan karakteristik audiens.

Strategi Optimasi Hasil Output Artificial Intelligence

Untuk mengoptimalkan output yang dihasilkan AI, terdapat berbagai strategi yang dapat diterapkan dalam prompt engineering. Pertama adalah roleplay mode, yaitu meminta AI berperan sebagai seorang ahli di bidang tertentu agar respons yang diberikan lebih sesuai dengan kebutuhan pengguna. Kedua adalah chain of thought, di mana AI diminta untuk berpikir secara bertahap sebelum memberikan jawaban akhir agar hasil yang diperoleh lebih logis dan rinci. Ketiga, self-review mechanism yang memungkinkan AI meninjau kembali jawabannya sebelum memberikan hasil akhir guna meningkatkan akurasi.

Keempat, simulated debating, dapat diterapkan dengan meminta AI menyajikan argumen pro dan kontra sebelum menarik kesimpulan, yang sangat berguna dalam analisis keputusan. Kelima, untuk meningkatkan relevansi jawaban, pengguna dapat menerapkan strategi clarification questions, yang memungkinkan AI mengajukan pertanyaan klarifikasi sebelum menjawab agar respons lebih sesuai dengan kebutuhan. Terakhir, time travel mode, yang dapat digunakan untuk meminta AI merespons dari perspektif masa depan untuk mengeksplorasi tren dan prediksi.

Penelitian menunjukkan bahwa penerapan teknik prompt engineering yang efektif dapat meningkatkan akurasi output LLM hingga 30%. Selain itu, penggunaan prompt yang spesifik dan detail juga terbukti mengurangi risiko halusinasi AI, sehingga menghasilkan respons yang lebih akurat dan dapat diandalkan.Sebuah studi juga menunjukkan bahwa prompt yang terstruktur dengan baik dapat mengurangi waktu revisi hingga 40% dan meningkatkan efisiensi kerja secara keseluruhan. Dengan memahami dan menerapkan teknik prompt engineering yang efektif, si penulis dapat menghemat waktu dan usaha dalam menghasilkan konten yang berkualitas.

Tantangan dalam Implementasi Prompt Engineering

Meskipun prompt engineering memiliki banyak manfaat dalam meningkatkan kualitas respons AI, terdapat sejumlah tantangan yang harus dihadapi dalam penerapannya. Salah satunya adalah ketergantungan pada struktur prompt, di mana AI masih mengalami kesulitan dalam memahami instruksi yang ambigu atau terlalu kompleks. Selain itu, bias dalam model AI juga menjadi perhatian, karena output yang dihasilkan dapat dipengaruhi oleh data latihannya, sehingga penyusunan prompt harus dilakukan dengan cermat.

Tantangan lainnya adalah keterbatasan interpretasi AI, karena meskipun AI dapat memberikan jawaban yang terstruktur dan canggih, pemahamannya masih terbatas dibandingkan dengan manusia. Selain itu, proses optimasi prompt biasanya memerlukan eksperimen berulang untuk mendapatkan hasil yang diinginkan, yang dapat menjadi tantangan tersendiri bagi pengguna.